- Os axiomas de Kolmogorov definem formalmente a probabilidade como uma medida não negativa, normalizada e σ-aditiva.

- A partir desses axiomas derivam-se propriedades como P(∅)=0, 0≤P(A)≤1, leis de soma e relações com complementares.

- Estruturas como espaço de probabilidade (Ω, F, P), probabilidade condicional e independência surgem diretamente desse quadro axiomático.

A pergunta “quais são os axiomas da probabilidade?” parece simples, mas a resposta leva a uma construção matemática bem sólida, que começou a ser organizada de forma rigorosa no século XX com o trabalho de Andrey Kolmogorov. Esses axiomas são a base de praticamente toda a teoria moderna da probabilidade, desde o estudo de jogos de azar até modelos estatísticos complexos usados em ciência de dados, finanças e engenharia.

Antes da formalização de Kolmogorov, a probabilidade era entendida de forma mais intuitiva, ligada à ideia de frequência ou de acaso, e diferentes matemáticos usavam interpretações diversas. Hoje, quando falamos em axiomas da probabilidade, estamos nos referindo a um conjunto mínimo de regras que qualquer função de probabilidade deve obedecer para que possamos fazer cálculos coerentes, evitar contradições e construir teoremas poderosos.

Intuição básica: experiências aleatórias e acontecimentos

Para entender os axiomas da probabilidade, o primeiro passo é saber o que é uma experiência aleatória e o que chamamos de acontecimento. Uma experiência aleatória é qualquer procedimento cujo resultado não pode ser previsto com certeza, embora conheçamos todos os resultados possíveis; exemplos clássicos são o lançamento de uma moeda ou de um dado.

Chamamos de espaço amostral, geralmente denotado por Ω, o conjunto de todos os resultados possíveis dessa experiência. Se lançamos uma moeda, por exemplo, o espaço amostral pode ser escrito como Ω = {H, T}, onde H representa “cara” e T representa “coroa”. Cada elemento de Ω é chamado de resultado elementar.

Um acontecimento (ou evento) é qualquer subconjunto de Ω que nos interesse observar. Assim, se a experiência for o lançamento de uma moeda, o conjunto {H} é o acontecimento “sai cara”, o conjunto {T} é o acontecimento “sai coroa” e o próprio Ω é o acontecimento “sai cara ou coroa”, ou seja, um acontecimento certo.

Alguns acontecimentos são especialmente importantes: o acontecimento impossível, o acontecimento elementar e o acontecimento certo. O conjunto vazio ∅ representa o acontecimento impossível, pois não contém nenhum resultado; um conjunto com um único elemento {ω}, com ω em Ω, representa um acontecimento elementar; e o próprio Ω é o acontecimento certo, aquele que ocorre sempre que a experiência é realizada.

A linguagem da teoria de conjuntos ajuda bastante no estudo de probabilidade. Se A e B são acontecimentos, então A ∩ B representa a ocorrência simultânea de A e B, A ∪ B representa a ocorrência de pelo menos um deles, e o complementar de A, muitas vezes escrito como ̄A ou Ω \ A, representa a “não ocorrência de A”. Essa notação e as propriedades dos conjuntos serão usadas direto na formulação dos axiomas.

Interpretações do conceito de probabilidade

Embora os axiomas de Kolmogorov forneçam a base matemática da probabilidade, a palavra “probabilidade” em si pode ser interpretada de várias maneiras. Historicamente, surgiram diferentes leituras do que significa atribuir um número P(A) a um acontecimento A.

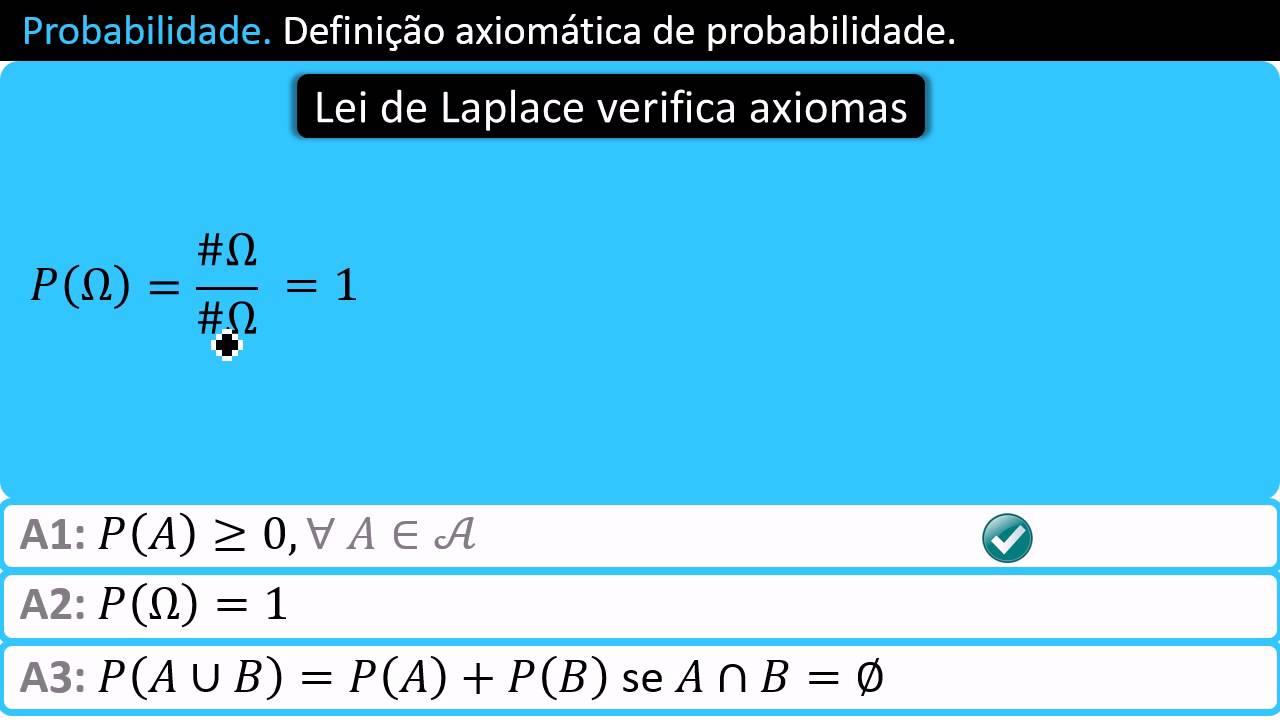

Na interpretação clássica de Laplace, válida para espaços finitos com resultados equiprováveis, a probabilidade de A é a razão entre o número de casos favoráveis e o número de casos possíveis. Se o espaço amostral tem n resultados igualmente prováveis (isto é, #Ω = n) e o acontecimento A contém n_A desses resultados (#A = n_A), então a probabilidade é dada por P(A) = n_A / n. Essa fórmula é bastante intuitiva quando todos os resultados têm a mesma chance de ocorrer.

Já a interpretação frequencista liga a probabilidade à frequência relativa observada em repetições de uma experiência. Nesse ponto de vista, repetimos a experiência aleatória n vezes e contamos quantas vezes o acontecimento A ocorre, chamando esse número de n_A; então olhamos para o limite, quando n cresce, da fração n_A / n. A probabilidade de A seria P(A) = lim_{n→∞} (n_A / n), desde que esse limite exista.

Existe também a interpretação subjetiva, muito usada em estatística bayesiana, na qual probabilidade está associada ao grau de crença de um sujeito racional. Nessa abordagem, P(A) quantifica o quão confiante alguém está na ocorrência de A, levando em conta o conhecimento disponível. Não é a experiência que “carrega” a probabilidade, mas o sujeito que avalia a incerteza de forma coerente.

Apesar dessas leituras diferentes, todas elas podem conviver dentro do mesmo arcabouço axiomático de Kolmogorov. Ou seja, independentemente de você preferir um ponto de vista clássico, frequencista ou subjetivo, no fim das contas a probabilidade será modelada matematicamente por uma função P que obedece a um pequeno conjunto de axiomas sobre um espaço de acontecimentos.

A construção formal: espaços de probabilidade e σ-álgebras

Kolmogorov descreveu a probabilidade em termos de um triplo (Ω, F, P), chamado de espaço de probabilidade. Nesse triplo, Ω é o espaço amostral, F é o conjunto de acontecimentos possíveis (tecnicamente, uma σ-álgebra de subconjuntos de Ω) e P é a função de probabilidade.

Uma σ-álgebra F é uma coleção especial de subconjuntos de Ω que satisfaz algumas propriedades. Em linhas gerais, F precisa conter o conjunto vazio, ser fechada para complemento (se A está em F, então o seu complementar também está) e ser fechada para uniões contáveis (se A₁, A₂, … estão em F, então a união de todos eles também está). Essa estrutura garante que possamos trabalhar com operações de conjuntos sem sair do universo de acontecimentos que têm probabilidade bem definida.

Formalmente, F é uma σ-álgebra sobre Ω quando: o conjunto vazio ∅ pertence a F; se A está em F, então o complementar de A em Ω também pertence a F; e se A₁, A₂, … é uma sequência (finita ou infinita contável) de elementos de F, então a união A₁ ∪ A₂ ∪ … também está em F. Em muitos contextos, F também é chamada de campo de Borel ou σ-campo.

A função de probabilidade P é definida sobre F e atribui a cada acontecimento E em F um número real não negativo. Dizemos então que P(E) está em ℝ e P(E) ≥ 0 para todo E em F. Em teoria de medida geral, medidas podem assumir valores infinitos, mas na teoria de probabilidade padrão, P(E) é sempre finita, o que traz algumas diferenças em relação a medidas mais gerais.

Essa estrutura (Ω, F, P) com P(Ω) = 1 é o que chamamos de espaço de probabilidade. A condição P(Ω) = 1 é essencial, pois representa a ideia de que, ao realizar a experiência, algum resultado em Ω certamente ocorre; não há “resultados escondidos” fora do espaço amostral.

Os três axiomas de Kolmogorov

A teoria axiomática de Kolmogorov baseia-se em três axiomas fundamentais que qualquer função de probabilidade deve satisfazer. Eles são simples de enunciar, mas extremamente poderosos, porque a partir deles se derivam praticamente todas as propriedades usuais da probabilidade.

Primeiro axioma — Não negatividade: para qualquer acontecimento A pertencente à σ-álgebra F, temos P(A) ≥ 0. Ou seja, probabilidades nunca são negativas. Em algumas teorias mais exóticas, fala-se em “probabilidades negativas”, mas essas ideias fogem do arcabouço clássico de Kolmogorov.

Segundo axioma — Normalização: a probabilidade do acontecimento certo é igual a 1, isto é, P(Ω) = 1. Esse axioma consagra a convenção de que 1 corresponde a 100% de certeza, e 0 corresponde à impossibilidade. Em versões mais elementares, esse axioma também pode ser entendido como dizendo que a soma das probabilidades de todos os resultados elementares de Ω é igual a 1.

Terceiro axioma — σ-aditividade: se A₁, A₂, … é uma sequência de acontecimentos disjuntos dois a dois (também chamados mutuamente exclusivos), então P(∪ᵢ Aᵢ) = Σᵢ P(Aᵢ). Isso vale tanto para uma coleção finita quanto para uma coleção infinita contável de acontecimentos. Essa propriedade de aditividade contável é a grande diferença em relação a uma mera aditividade finita.

Em contextos mais simples, alguns autores trabalham apenas com aditividade finita, exigindo que P(A ∪ B) = P(A) + P(B) para acontecimentos disjuntos A e B, e que isso se estenda a um número finito de conjuntos. Nesse caso, basta trabalhar com uma álgebra de conjuntos, não necessariamente uma σ-álgebra, mas a abordagem padrão em probabilidade moderna é exigir σ-aditividade.

É a partir desse terceiro axioma que surgem várias consequências importantes, como igualdades, desigualdades e leis da probabilidade. Ele também está no coração da ligação da probabilidade com a teoria de medida, que estuda medidas em conjuntos de forma bastante geral.

Propriedades derivadas dos axiomas

A partir dos três axiomas de Kolmogorov, conseguimos provar diversas propriedades básicas e extremamente úteis. Essas propriedades não são supostas de antemão: elas são consequências lógicas dos axiomas.

Uma das primeiras propriedades é a monotonicidade da probabilidade. Se A e B são acontecimentos em F e A está contido em B (A ⊆ B), então P(A) ≤ P(B). A ideia é intuitiva: se B engloba tudo o que pode acontecer em A, e talvez mais, então B não pode ter probabilidade menor do que A.

Outra propriedade fundamental é que a probabilidade do acontecimento impossível é zero. Do ponto de vista formal, usando a σ-aditividade, consideramos uma sequência em que E₁ = A, E₂ = B \ A e Eᵢ = ∅ para i ≥ 3, em um cenário em que A ⊆ B. Como os Eᵢ são disjuntos e sua união é B, a soma das probabilidades precisa convergir para P(B). Se supusermos que P(∅) = a > 0, então a soma de P(∅) infinitas vezes explodiria para infinito, o que é incompatível com P(B) finita. Daí concluímos que P(∅) = 0.

Com isso, podemos afirmar a desigualdade 0 ≤ P(E) ≤ 1 para qualquer acontecimento E em F. Já sabíamos que P(E) ≥ 0 pelo primeiro axioma. Sabendo que P(Ω) = 1 e usando a monotonicidade com E ⊆ Ω, vem que P(E) ≤ P(Ω) = 1. Assim, toda probabilidade está sempre entre 0 e 1, inclusive.

Uma identidade muito utilizada é a chamada lei aditiva para dois acontecimentos quaisquer. Para acontecimentos A e B em F, vale que P(A ∪ B) = P(A) + P(B) − P(A ∩ B). Essa fórmula corrige o “duplo contagem” do acontecimento comum A ∩ B, que é adicionado duas vezes se somarmos P(A) e P(B) sem ajuste.

Outra consequência importante é a relação entre um acontecimento e o seu complementar. Se indicarmos o complementar de A por ̄A, então P(̄A) = 1 − P(A). Essa igualdade traduz a ideia de que “ou A acontece ou A não acontece”, e não há outra possibilidade dentro de Ω.

A partir daí, também fica claro que P(A) = 0 não implica necessariamente que A seja o acontecimento impossível. Em termos matemáticos, é possível que um acontecimento tenha probabilidade zero sem ser o conjunto vazio (isso aparece, por exemplo, em espaços contínuos), mas no nível mais elementar costuma-se associar P(A) = 0 a eventos praticamente impossíveis.

Exemplo prático: lançamento de uma moeda

Um exemplo clássico e muito didático para visualizar os axiomas de Kolmogorov é o lançamento de uma moeda. Vamos supor, para começar, que a moeda só pode dar “cara” (H) ou “coroa” (T), e que esses são os únicos resultados possíveis.

Definimos então o espaço amostral como Ω = {H, T}. Os acontecimentos possíveis formam uma σ-álgebra F composta por {∅, {H}, {T}, {H, T}}. Nesse contexto, o acontecimento impossível é ∅, os acontecimentos elementares são {H} e {T}, e o acontecimento certo é {H, T}.

Pelos axiomas de Kolmogorov, sabemos que P(∅) = 0 e P(Ω) = 1. Se assumirmos que a moeda é honesta, isto é, não favorece nenhum dos lados, então a simetria sugere que P({H}) = P({T}). Como a soma P({H}) + P({T}) precisa ser igual a 1, concluímos que ambos valem 1/2.

Desse modo, a probabilidade de sair “cara ou coroa” é P({H, T}) = 1, a probabilidade de sair “cara” é P({H}) = 1/2 e a probabilidade de sair “coroa” é P({T}) = 1/2. A soma das probabilidades dos acontecimentos elementares esgota a probabilidade total do espaço.

Esse modelo, embora simples, ilustra como os axiomas se comportam na prática e como eles evitam inconsistências em cálculos de probabilidade. Se não definirmos cuidadosamente o espaço amostral, podemos cometer erros graves, porque qualquer acontecimento é sempre um subconjunto de Ω; se o subconjunto não se encaixa em Ω, a sua probabilidade nem sequer está definida.

Probabilidade em espaços finitos e contáveis

Quando o espaço de resultados é finito ou contável, a probabilidade pode ser descrita de forma bastante concreta. Suponha que Ω = {ω₁, ω₂, …} seja um conjunto finito ou contável de resultados possíveis.

Se A é um acontecimento que contém alguns desses resultados, como A = {ω₁*, …, ω_{k*}, …}, então a probabilidade de A pode ser vista como a soma das probabilidades dos acontecimentos elementares correspondentes: P(A) = P(∪ᵢ {ω_{i*}}) = Σᵢ P({ω_{i*}}). Isso é uma aplicação direta da aditividade (ou σ-aditividade) sobre conjuntos disjuntos.

No caso particular em que o espaço amostral é finito, com #Ω = n, e todos os resultados são equiprováveis, temos P({ωᵢ}) = 1/n para cada i. Se A contém k resultados distintos em Ω, então P(A) = Σ_{i=1}^k P({ω_{i*}}) = k/n = (#A)/(#Ω). Essa é exatamente a fórmula clássica de Laplace reinterpretada dentro da estrutura axiomática moderna.

Quando o espaço de resultados é contável infinito, a soma das probabilidades dos acontecimentos elementares ainda precisa convergir para 1. Ou seja, Σᵢ P({ωᵢ}) = 1. É aqui que a σ-aditividade mostra sua força, permitindo tratar não só somas finitas, mas também séries infinitas de acontecimentos.

Probabilidade condicional e papel dos axiomas

Um aspecto central da teoria é entender como a probabilidade muda quando sabemos que certo acontecimento já ocorreu. É aí que entra a probabilidade condicional, normalmente escrita como P(A | B), que significa “probabilidade de A dado que B ocorreu”.

A fórmula básica para a probabilidade condicional é P(A | B) = P(A ∩ B) / P(B), desde que P(B) > 0. Essa definição é compatível com os axiomas de Kolmogorov, e na verdade, para cada B com P(B) > 0, a função A ↦ P(A | B) satisfaz novamente os três axiomas quando restringimos o espaço de acontecimentos a B.

Isso significa que P(· | B) é, ela própria, uma função de probabilidade sobre o “novo” espaço amostral B. Como consequência, todas as propriedades básicas valem para probabilidades condicionais: P(̄A | B) = 1 − P(A | B), P(∅ | B) = 0, monotonicidade condicionada (se A₁ ⊆ A₂, então P(A₁ | B) ≤ P(A₂ | B)) e a fórmula P(A₁ ∪ A₂ | B) = P(A₁ | B) + P(A₂ | B) − P(A₁ ∩ A₂ | B).

Da definição de probabilidade condicional deriva também a importante relação P(A ∩ B) = P(A) P(B | A), quando P(A) > 0. Simetricamente, podemos escrever P(A ∩ B) = P(B) P(A | B), desde que P(B) > 0. Essas igualdades ajudam a decompor probabilidades conjuntas e são a base para vários resultados, como o Teorema de Bayes.

É interessante notar que a probabilidade “sem condição” pode ser vista como um caso particular de probabilidade condicional. De fato, podemos escrever P(A) = P(A ∩ Ω) / P(Ω) = P(A | Ω), já que P(Ω) = 1. Isso reforça a ideia de que, conceitualmente, toda probabilidade é condicional a alguma informação de fundo, mesmo que seja apenas o conhecimento de que estamos trabalhando dentro de Ω.

Independência de acontecimentos

Outro conceito-chave que se apoia nos axiomas é o de independência entre acontecimentos. Dois acontecimentos A e B são independentes se a ocorrência de um não altera a probabilidade do outro.

Na linguagem formal, A e B são independentes quando P(A ∩ B) = P(A) P(B). Em termos de probabilidade condicional, isso implica que, se P(B) > 0, então P(A | B) = P(A), e se P(A) > 0, então P(B | A) = P(B). Ou seja, saber que B ocorreu não muda a probabilidade de A, e vice-versa.

Todo acontecimento é independente do acontecimento impossível ∅ e do acontecimento certo Ω. Para o conjunto vazio, P(A ∩ ∅) = 0 e P(∅) = 0, então a relação trivialmente se mantém. Para o acontecimento certo, P(A ∩ Ω) = P(A) e P(Ω) = 1, logo P(A ∩ Ω) = P(A) P(Ω) = P(A).

Uma pergunta comum é se dois acontecimentos disjuntos podem ser independentes. De modo geral, se A e B são disjuntos e ambos têm probabilidade positiva, então P(A ∩ B) = 0, mas P(A) P(B) > 0, o que viola a definição de independência. Assim, em muitos casos, dois acontecimentos disjuntos com probabilidade não nula não são independentes, pois a ocorrência de um exclui a possibilidade do outro.

Quando lidamos com mais de dois acontecimentos, surgem várias noções diferentes de independência. Podemos ter independência par a par, independência conjunta e outros tipos. Em todos esses casos, porém, o ponto de partida continua sendo a relação P(A ∩ B) = P(A) P(B), fundamentada nos axiomas de Kolmogorov e na definição de probabilidade condicional.

Regras práticas e leis clássicas da probabilidade

Além das propriedades formais, os axiomas permitem enunciar leis mais operacionais, úteis no dia a dia de quem faz cálculos de probabilidade. Uma delas é a chamada lei da soma, já mencionada na forma P(A ∪ B) = P(A) + P(B) − P(A ∩ B), que pode ser estendida para um número maior de acontecimentos por meio do princípio de inclusão-exclusão.

Outra regra muito usada é a relação entre um acontecimento e sua parte “fora” de outro acontecimento. Para A e B em F, vale P(A ∩ ̄B) = P(A) − P(A ∩ B). Isso nada mais é do que decompor A em duas partes: a que ocorre junto com B (A ∩ B) e a que ocorre sem B (A ∩ ̄B). Essas duas partes são disjuntas e sua união é A, o que leva à igualdade anterior pela aditividade.

A lei da probabilidade total e o Teorema de Bayes, embora não estejam totalmente detalhados aqui, também se apoiam diretamente nos axiomas. A lei da probabilidade total combina probabilidades condicionais em uma partição do espaço amostral, enquanto o Teorema de Bayes “inverte” condicionais, permitindo atualizar probabilidades a partir de novas evidências.

Em versões mais didáticas, também se listam alguns “axiomas práticos” fáceis de memorizar, como: a probabilidade máxima é 1 (100%); a soma das probabilidades de todos os elementos do espaço amostral é igual a 1; e a probabilidade de um evento X somada à probabilidade de “não X” é sempre 1. Esses enunciados são reflexos diretos dos axiomas formais.

Com esse conjunto de leis, torna-se possível resolver problemas que vão desde jogos de azar simples até modelos sofisticados com muitas variáveis. A grande vantagem é que, por trás de todas as fórmulas e truques de cálculo, o suporte lógico continua sendo o mesmo tripé axiomático.

Os axiomas da probabilidade de Kolmogorov fornecem uma base rigorosa e ao mesmo tempo flexível para lidar com incerteza. A partir de três princípios simples — não negatividade, normalização e σ-aditividade — foi construída toda uma teoria rica, capaz de incorporar interpretações clássicas, frequencistas e subjetivas, tratar espaços finitos ou infinitos, descrever probabilidades condicionais e independência e ainda sustentar aplicações em praticamente todas as áreas científicas e tecnológicas.